Mord im Smart Home – Inspektor Columbo ermittelt!

2. März 1975: "Replay" – Columbo ermittelt gegen Oskar Werner!

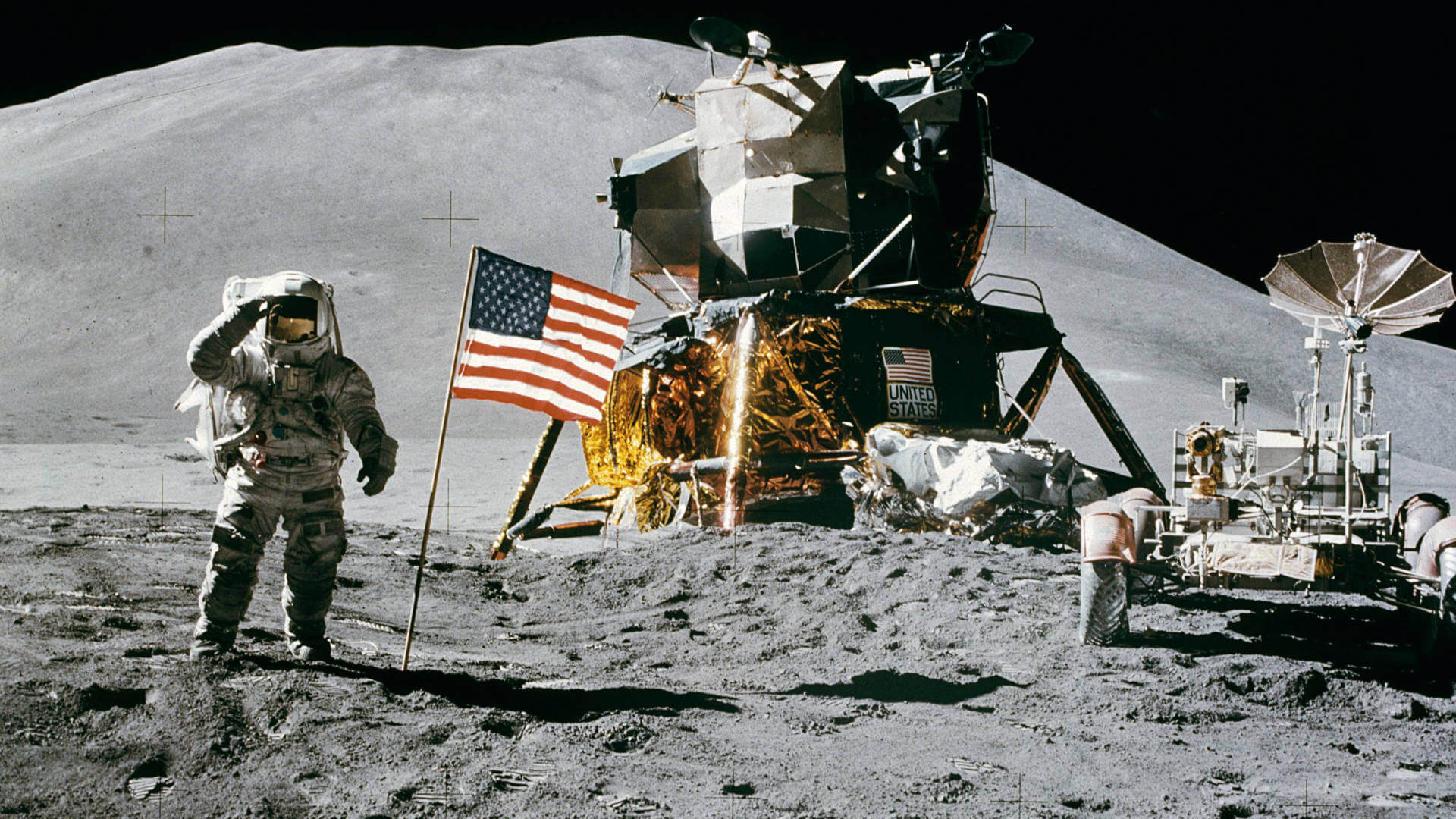

1975, eine geschichtsträchtige Epoche der Menschheit endet. Die 1961 gestartete US-amerikanische Apollo Mission ist abgeschlossen. Das Wettrennen der UDSSR mit den USA um die Vorherrschaft im Weltraum war entschieden. Rund um den Globus war eine Begeisterung für Technologie ausgebrochen. Alles schien machbar zu sein, auch im täglichen Leben wirkte die Apollo Mission. Abfallprodukte wie Teflon fanden ihren Platz in der Küche, Texas Instrument Taschenrechner zogen in die Klassenzimmer ein, auf denen mit einem einfachen Programm „Mondlandung“ gespielt werden konnte.

Auch Hollywood war fasziniert vom Weltall und den revolutionären Technologien, die aus dem Apollo Programm hervorgingen. Steven Spielberg begeisterte 1977 Cineasten mit „Unheimliche Begegnung der dritten Art“ und Inspektor Columbo ermittelte gegen Harold van Wyck, dargestellt von Oskar Werner, Chef eines Elektronik Konzerns, der ein „voll technologisiertes Haus“ erdacht hatte.

Das erste Smart Home der Geschichte im Film. So stellte sich Hollywood das Haus der Zukunft vor. Die an den Rollstuhl gefesselte Schwiegermutter von Harold van Wyck konnte mit Gesten Türen öffnen, Licht an und aus schalten und mehr. Das Anwesen war natürlich komplett videoüberwacht, ein Novum. Die von Wyck ersonnene Überwachungstechnik und Gestensteuerung überführte ihn später als Mörder seiner Schwiegermutter. Smart Home und Überwachung, Alexa und Co. – auch heute wieder Thema in Mordermittlungen. „Replay“ – ein Blick in die Zukunft.

Eine Frage hätte ich da noch: „Was ist eine Geste, Herr Professor?“

„Eine Frage hätte ich da noch!“, der legendäre Satz des Inspektor Columbo, der in nervtötend quälender Art den Dingen auf den Grund ging. „Was ist eine Geste?" – scheint eine mehr wissenschaftliche Frage zu sein, als von Praxisbezug für die Mensch-Maschine-Kommunikation zu sein. Doch wer Maschinen beibringen will, menschliche Gesten zu verstehen, wird schnell feststellen: Die Frage hat mehr Praxisbezug als erwartet.

Die Gestikforschung ist eine junge Wissenschaft. Sie etablierte sich erst Mitte der 1990er Jahre und ist zwischen Linguistik und Psychologie angesiedelt. Als Geste versteht sie eine Kopf-, Hand- oder Ganzkörperbewegung in Verbindung mit Sprache. D.h. im wissenschaftlichen Sinn sind beispielsweise die bekannten Smartphone „Gesten“ keine Gesten im eigentlichen Sinn. Die sprachlichen Komponenten fehlen ihnen. Das zeigt bereits das erste Problem der Mensch-Maschine-Kommunikation in Bezug auf Gesten. Aktuell funktioniert sie nur über „erfundene“ diskrete Gesten ohne sprachliche Komponente. Maschinelles Verstehen menschlicher Alltagsgesten, davon ist die Technologie noch ein gutes Stück entfernt.

Gesten analytisch betrachtet.

Um Maschinen „echte“ menschliche Gesten „verständlich“ zu machen, muss der zeitliche Ablauf (immanente Voraussetzungen für eine Geste) analytisch betrachtet werden. Typischer Weise besteht eine Geste aus drei bis vier Phasen: Preperation – Stroke – Recover – evtl. Re-Stroke. Ein Beispiel für eine diskrete Geste: Nehmen wir an, jemand möchte eine Kugel Eis von einer Sorte kaufen, deren Namen er nicht kennt.

Die Kommunikation mit dem Eisverkäufer wird in etwa so ablaufen:

- Preperation: Hand heben und mit ausgestrecktem Zeigefinger auf die gewünschte Eissorte zeigen.

- Stroke: Die Position wird gehalten und dazu folgt, die Geste abschließend, die verbale Komponente: „dieses bitte“.

- Recovery: Die Hand wird abgesenkt.

Wurde die Geste nicht richtig verstanden, weil z.B. 25 unterschiedliche Sorten aufgereiht sind und der Eisverkäufer zur falschen Sorte griff, erfolgt die letzte Phase: - Re-Stroke: Beispielsweise erneutes Zeigen in Verbindung mit der verbalen Äußerung „nein diese dort bitte“.

Alleine dieses einfache Beispiel macht transparent, wie komplex maschinelles Verstehen der einfachsten Alltagsgesten sein wird. Gesten, die nicht für Computer erfunden wurden. Eine Gesten Kommunikation, in der sich nicht der Mensch auf die Maschine einstellt, sondern umgekehrt die Maschine den Menschen deuten muss.

Auch das Pokerface ist eine wichtige Geste.

Im klassischen Verständnis setzt eine Geste eine Bewegung voraus. Eine Geste ist also etwas Dynamisches, eine Bewegung, die über eine Zeitachse läuft und immer mit einem verbalen Akt abgeschlossen wird. Dynamische Gesten treten in Form „diskreter Gesten“ oder „kontinuierlicher Gesten“ auf. Ersteres ist beispielsweise das Zeigen auf etwas, eine „kontinuierliche Geste“, führt beispielsweise ein Dirigent aus. Das scheint alles noch maschinell gut lösbar zu sein.

Neue Ansätze in der Gestenforschung, gerade in Bezug auf Mensch-Maschine-Kommunikation, stellen jedoch fest: Nur Bewegungen als Gesten zu sehen, ist in einer Gestik 4.0 zu kurz gegriffen. Menschen interpretieren auch Statisches im Gesamtkontext. Das ‚nicht Antworten‘ auf eine Frage kann auch eine bewusste Geste darstellen, kann gezielt Ignoranz senden. Das Zeigen eines „Thumbs-up“ beispielsweise ist ebenso eine Geste, die zum Verständnis weder eine Bewegung noch eine „Stroke“ Komponente, also eine verbale Komponente, benötigt.

Die Komplexität steigt – kulturelles Umfeld, zeitlicher Kontext und mehr.

Wird noch tiefer in die Materie einer potentiellen Mensch-Maschine Gesten-Kommunikation eingedrungen, stößt man auf eine Fülle weiterer Probleme. Diskrete Gesten werden durch die hohe Rechenleistung von Smartphones bereits relativ treffsicher über den Abgleich mit Musterdatenbanken interpretiert, falls das Gerät die richtige „kulturelle Datenbank“ zur Verfügung hat. Gesten, die in Europa Freundliches signalisieren, können in Nahost oder Asien beleidigend sein. Das lässt sich über GPS Daten und entsprechende Musterdatenbanken noch zumindest teilweise lösen.

Die Komplexität steigt weiter, wenn verstanden wird, dass Gesten auch einer kulturellen und zeitlichen Entwicklung unterliegen. Um Gesten im Alltag richtig zu interpretieren, bedarf es eines Verständnisses des Gegenübers: Alter, soziale Schicht, kulturelle Basis und mehr. Ein Mensch sieht dies, eine Maschine nicht.

Multisensorik und Machine Learning.

Erste Schritte in der Mensch-Maschine-Kommunikation sind gegangen. Aber auch nicht mehr. Die klassische Gestenforschung nimmt an, dass all die Erfahrung und Sinnesorgane, die einem Menschen zur Verfügung stehen, um eine Geste zu interpretieren, eine gegebene Tatsache sind.

In der Mensch-Maschine-Kommunikation ist das nicht der Fall. Eine Bewegung zu analysieren und einen Musterdatenbankvergleich anzustoßen, ist zu wenig. Die sprachliche Komponente muss ergänzt werden und vor allem muss die Maschine wissen, in welchem situativen Umfeld die Geste stattfindet und von wem und an welchem Ort sie ausgeführt wurde.

Maschinelles Interpretieren echter menschlicher Gesten mit all ihren individuellen Facetten setzt die Analyse und Interpretation eines immensen Datensets aus unterschiedlichsten Sensoren voraus. Zeitreihendaten aus multiplen Sensoren, die harmonisiert und hoch performant analysiert und interpretiert werden müssen. Die Herausforderungen scheinen enorm aber machbar.

Weiter lesen: Sensoren und Interpretation.

Mensch-Maschine-Kommunikation, Gestik 4.0 oder wie immer es bezeichnet werden soll, ist eines der brennenden Zukunftsthemen. Wie gut das Thema gelöst werden wird, wird u.a. die Qualität der Altenpflege maßgeblich mit beeinflussen.

Dieser Beitrag widmete sich im Rahmen einer Trilogie dem Zukunftsthema Gesten in einer Basisbetrachtung. In den beiden folgenden Artikeln werden Ansätze der Sensorik, gefolgt von jenen zur Analyse und Interpretation – Big Data mit Zeitstempel – beleuchtet.

Den Autor Stefan Komornyik kontaktieren.